L’intelligence artificielle : penser autrement

Les machines seront-elles bientôt plus intelligentes que les êtres humains ? Un expert en IA nous explique où en est la technologie, où elle va et ce qui doit nous inquiéter.

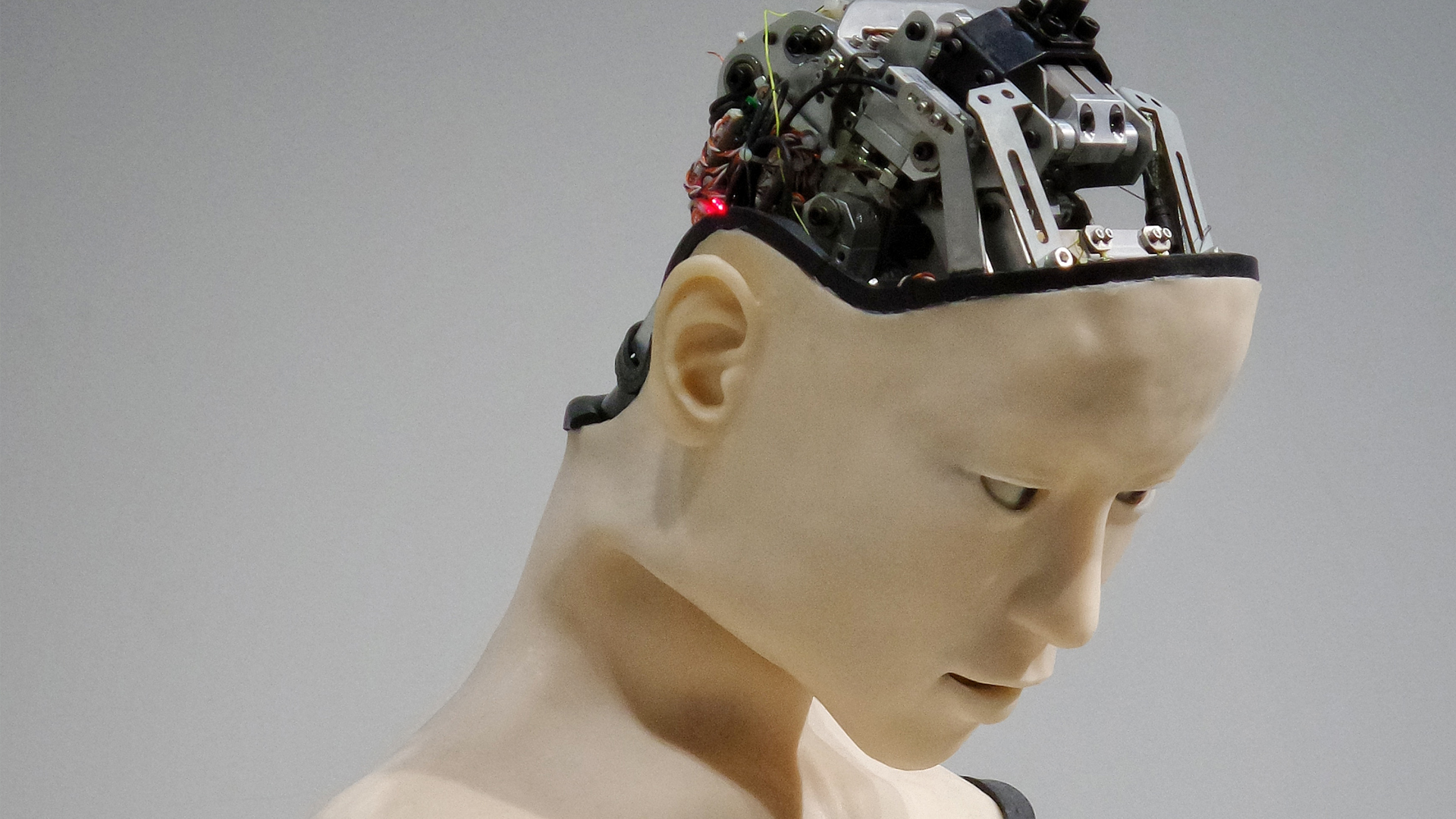

L’intelligence artificielle (IA) ne relève plus de la science fiction. Si les robots-femmes de ménage n’existent pas encore, les chercheurs travaillent aujourd’hui d’arrache-pied pour créer des machines qui raisonnent, résolvent les problèmes et dont le « cerveau » arrive à rivaliser avec le nôtre. Faut-il s’en inquiéter ?

Certes, Seán Ó hÉigeartaigh (ou Sean O’Hegarty) se réjouit des avantages que pourra représenter l’IA, mais il se méfie également des aspects plus sombres de la technologie. Titulaire d’un doctorat en génomique de Trinity College à Dublin, il est actuellement directeur exécutif du Center for the Study of Existential Risk (centre d’étude sur le risque existentiel) à Cambridge et il a joué un rôle essentiel dans la recherche internationale sur les impacts et les risques à long terme de l’IA.

David Hulme, éditeur de Vision, s’est entretenu avec lui non seulement sur l’état actuel de la technologie, mais sur ce que l’avenir nous réserve dans ce domaine.

Seán Ó hÉigeartaigh, directeur exécutif du Center for the Study of Existential Risk à l’université de Cambridge

DH Comment pourrait-on résumer brièvement l’historique de l’IA ?

SOH On peut dire que l’idée de l’intelligence artificielle est apparue dans les années 1950. Certaines de ces idées existaient déjà plus ou moins, mais l’année 1956 marqua un point réellement charnière, lorsqu’une conférence organisée à Dartmouth rassembla certains des penseurs les plus brillants qui soient dans le domaine de l’informatique et d’autres domaines ; ces derniers s’attelèrent à la tâche de créer des machines capables de penser et de raisonner comme des êtres humains. Ils étaient animés par un grand optimisme et une immense ambition. Ils s’imaginaient que beaucoup des obstacles auxquels nous sommes confrontés depuis soixante ans seraient éliminés en quelques années seulement et que des projets tels que la vision artificielle et la traduction automatique seraient certes ardus mais réalisables en quelques mois, grâce au travail d’une petite équipe.

Il me semble qu’il s’agit du point de départ officiel du domaine de l’intelligence artificielle.

DH Est-ce que nous progressons comme nous l’avions escompté à l’époque ?

SOH Je ne le pense pas, mais il y a des progrès. Comme dans de nombreux autres domaines scientifiques, la création de l’intelligence artificielle s’est avérée beaucoup plus complexe que ce que les apparences avaient pu mener à croire au début.

Avec le recul, ceci n’est sans doute pas surprenant. L’intelligence fait partie de ce qui est le plus complexe au monde. L’idée que l’on puisse la recréer ou créer un équivalent en l’espace de quelques mois ou de quelques années était sans doute quelque peu optimiste. Au cours des quelques 60 années passées, on a pu assister à des avancées soudaines, suivies de ralentissements apparents, que l’on caractérise d’étés et d’hivers de l’IA. Plus d’une fois, des approches spécifiques, au départ fructueuses, se sont finalement terminées en impasses.

Beaucoup des progrès effectués au cours des dix dernières années sont dus à une approche que l’on appelle l’apprentissage automatique. Il s’agit d’une approche unique puisque la programmation des systèmes d’apprentissage automatique n’est pas strictement limitée à une série précise d’étapes à suivre. Au contraire, ces systèmes peuvent analyser des données et soit agir en conséquence, soit trouver une réponse sans avoir été programmés de manière spécifique pour la tâche en question.

DH Vous travaillez à la fois sur le concept du risque existentiel et au développement de l’IA. Selon une citation de votre collègue Nick Bostrom, « la transition à l’ère de l’intelligence de la machine semble être un évènement capital qui à mon avis comporte un risque existentiel significatif ». Si ceci est vrai, quel est le risque et peut-on le qualifier d’existentiel ?

SOH Ce qu’il faut bien comprendre, c’est que lorsque Nick Bostrom parle de la transition à l’intelligence de la machine et du risque existentiel, il ne fait pas référence aux systèmes d’intelligence artificielle tels qu’ils existent dans le monde d’aujourd’hui. Il pense à l’avenir et à l’avènement de ce qu’on pourrait appeler « l’intelligence globale artificielle », à savoir le type d’intelligence globale du raisonnement et de la résolution des problèmes qui nous permet de dominer notre environnement comme nous, espèce humaine, l’avons fait. Nous n’en sommes pour l’instant absolument pas là et les experts divergent quant au temps qu’il nous faudra pour y parvenir. Mais il est fort probable qu’il faudra plus qu’une décennie et même selon certains, plusieurs décennies. Ceci étant, si on y arrive, le monde en sera tellement bouleversé qu’il nous est difficile d’imaginer à quoi cela ressemblera.

« Il est imprudent de supposer que si on arrivait à créer une intelligence équivalente, voire même supérieure à la nôtre, tout se passerait très bien. »

Plus que toute autre espèce, nous avons nui à notre propre environnement. Nous éliminons des espèces à un rythme effréné. Nous changeons notre climat au point que notre avenir pourrait ne plus être durable. Si nous décidons d’introduire dans ce monde l’intelligence, que ce soit sous forme d’outils ou sous forme d’entités indépendantes nous permettant de changer encore davantage le monde, il nous faut prendre le temps de bien réfléchir aux objectifs que nous leur donnons et au niveau d’autonomie que ces systèmes futurs pourront avoir, car il pourrait être très difficile de revenir en arrière.

Il ne s’agit pas là de l’IA dont nous disposons dans le monde d’aujourd’hui, de demain ou de l’année prochaine. Pourtant il me semble réellement salutaire de réfléchir en amont pour savoir si nous sommes engagés sur cette voie et pour penser aux étapes à suivre.

DH Dans le rapport de février 2018 intitulé « The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation » (l’usage malveillant de l’intelligence artificielle : prévisions, prévention et atténuation), vous écrivez : « L’intelligence artificielle change la donne. Ce rapport spécule sur ce à quoi le monde pourrait ressembler dans les cinq ou dix années à venir. » Vous notez plus loin : « Notre rapport est un appel à l’action adressé aux institutions gouvernementales et aux particuliers du monde entier. » Quelle a donc été la réaction des autorités publiques, des entreprises et des particuliers ?

SOH La réaction a en fait été très positive. Au début, nous craignions d’être accusés d’alarmisme, ce qui n’était en aucun cas notre intention. L’idée, c’était que tous les auteurs, qui pour beaucoup d’entre eux sont impliqués eux-mêmes dans le développement de l’intelligence artificielle, puissent identifier les usages potentiellement négatifs et les atténuer, afin de promouvoir les usages positifs qui nous intéressent tous. Nous avons été très heureux de constater que le rapport a été interprété dans ce sens. Nous avons reçu des commentaires tout à fait positifs et nous sommes en train d’organiser des ateliers de suivi. Les auteurs ont tous reçu plusieurs invitations à présenter les conclusions du rapport. (Je rentre tout juste d’une réunion avec des experts de l’ONU organisée par l’université des Nations unies.)

Une de nos principales recommandations consistait à expliquer qu’avec le rythme auquel l’intelligence artificielle se développe et avec son application à autant de systèmes différents dans le monde pour lesquels la sécurité est critique, nous devons mettre en place une meilleure collaboration entre les experts en apprentissage automatique, qui comprennent bien la technologie de pointe ; les décideurs politiques et les juristes, qui doivent légiférer sur ces sujets et guider les stratégies publiques ; et les personnes impliquées dans l’infrastructure civile, ainsi que les théoriciens des sciences sociales, qui doivent réfléchir à la question de l’impact. Ce qui nous interroge particulièrement, c’est les possibilités d’abus ou d’adaptation quelles qu'elles soient par certaines personnes des avancées inoffensives de l’intelligence artificielle à des fins nocives, pour essayer d’y faire obstacle.

DH Quelles sont les principales applications de l’IA qui doivent nous inquiéter ?

SOH Nous avons considéré trois domaines spécifiques : le domaine du numérique (qui correspond par exemple aux cyberattaques et à la cyberdéfense), le domaine matériel (attaques potentielles de l’infrastructure matérielle) et le domaine politique (les progrès de la surveillance, la propagande automatisée, en ciblant tout ce qui pourrait permettre à des acteurs malveillants de saboter les processus politiques ou de perturber les discussions et débats ouverts).

Nous avons identifié trois grandes tendances qui se recoupent dans ces trois domaines. La première : l’intelligence rendra possible une propagation plus large des menaces auxquelles nous sommes actuellement confrontés. La deuxième : elle introduit de nouveaux types de menaces qui, pour être atténuées, nécessiteront de nouvelles approches. Et enfin, l’intelligence changera la nature des menaces auxquelles nous sommes confrontés, de plusieurs manières.

Voici un exemple de la propagation plus large des menaces : Actuellement, dans le domaine des cyberattaques, il existe une différence énorme en termes d’efficacité entre ce qu’on appelle le harponnage (spear phishing) et ce qu’on appelle le hameçonnage (phishing). Le hameçonnage, c’est une personne qui envoie un e-mail malveillant pour essayer de vous convaincre de cliquer sur un lien nuisible, par exemple. Si vous recevez un message provenant d’un prince nigérian qui vous offre 50 millions de dollars, vous allez probablement vous dire « non merci » et mettre le message de côté. Le harponnage, par contre, implique généralement une personne ou un groupe de personnes qui consacrent un certain temps à vous identifier comme cible particulièrement intéressante. Elles vont chercher à connaître tout ce qu’elles peuvent sur vous, de manière à concocter une attaque spécifique, qui vous semblera convaincante.

« Vous avez l’impression que ça vient d’une personne de confiance, ou alors suffisamment d’informations personnelles sont incorporées pour que vous ne vous doutiez pas qu’il s’agit d’une attaque malveillante. Ces attaques sont beaucoup plus efficaces. Même les experts en cybernétique et en sécurité se font prendre au piège. »

Actuellement, le nombre de ces attaques particulièrement efficaces est limité car elles requièrent énormément de temps et d’expertise humaine. Mais si on parvient à automatiser une grande partie du processus, ce dernier deviendra soudainement accessible à un nombre beaucoup plus important d’acteurs, pour un coût bien inférieur. Imaginons par exemple qu’un système automatique vous scanne et vous identifie comme cible particulièrement intéressante, à cause d’un organisme dont vous faites partie, ou à cause de votre richesse ou de vos activités types. Le système pourrait collecter un grand nombre d’informations sur vous, votre profil sur les réseaux sociaux, vos activités. Ensuite, en automatisant diverses composantes du processus, il arriverait à vous leurrer dans le cadre d’une attaque, soit en contribuant à la rédaction d’un message sur lequel vous êtes davantage susceptible de cliquer, soit en incorporant des éléments d’information qui donnent l’impression que ce message vous concerne, voire même en utilisant des voix ou des images synthétiques. Il est aujourd’hui possible pour quelqu’un de transformer un message enregistré avec sa propre voix en un message qui semble avoir été enregistré par une de vos connaissances (si suffisamment d’échantillons de la voix de la personne sont disponibles). Il existe donc soudainement des outils permettant une attaque plus sophistiquée et potentiellement accessible beaucoup plus largement que par le passé.

Au jour d’aujourd’hui, seul un groupe disposant d’énormément de ressources pourrait mettre au point un autre Stuxnet ou causer une défaillance du réseau électrique ukrainien. Et pourtant, si de nombreux aspects de ce qui rend une attaque difficile pour des raisons d’expertise, de temps et de ressources en viennent à être automatisés, il sera possible que l’on constate un nombre plus important de ce type d’attaques.

Les systèmes d’intelligence artificielle eux-mêmes peuvent être attaqués différemment des systèmes informatiques traditionnels. Par exemple, dans une attaque antagoniste, si on infiltre un certain type d’image ou un certain type de pixels dans un système, on peut donner au système la fausse impression qu’il voit quelque chose qu’il ne voit pas réellement. Il a été prouvé, par exemple, que si on change ne serait-ce que quelques pixels sur un panneau stop vu par un véhicule autonome, le véhicule considère qu’il s’agit d’un panneau lui indiquant qu’il peut continuer. On peut imaginer ce qu’une telle application utilisée à grande échelle pourrait provoquer en termes d’accidents. Ceci étant, il me semble qu’il y aura suffisamment de témoins observant ces voitures autonomes pour que ce scénario ne se produise pas de la sorte. Mais si nous prévoyons d’introduire ces systèmes dans tous les domaines, depuis la santé au transport, en passant par l’infrastructure civile, il nous faut réfléchir aux nouveaux risques d’attaque de ces systèmes.

Autre exemple dans le domaine matériel ; actuellement, il serait impossible pour un être humain de diriger un essaim de drones ou une flotte de petits robots volants. Par contre, l’intelligence artificielle pourrait assurer la coordination et la communication entre ces drones et donc rendre éventuellement possible une attaque extrêmement puissante. Il s’agirait d’une arme totalement nouvelle et qui pourrait être rendue accessible dans les cinq à dix années à venir.

DH Martin Rees parle du danger des risques existentiels causés par des acteurs dévoyés lorsqu’il prononce son fameux : « Il faut bien, dans le village mondial, des idiots du village. » Ces personnes sont-elles les seules à qui vous cherchez à mettre des bâtons dans les roues ?

SOH Il est évident qu’il faut à mon avis s’occuper des acteurs isolés et des idiots du village. Ce qui est préoccupant, entre autres, c’est que les progrès de l’intelligence artificielle et des biotechnologies (et Martin a beaucoup écrit sur cette question) pourraient permettre au loup solitaire de nuire de manière plus sophistiquée et avec des conséquences plus graves que par le passé. Toutefois, il me semble qu’écarter des acteurs non étatiques, voire mêmes des acteurs étatiques plus puissants serait sans doute faire preuve de naïveté. Nous avons pu constater au cours de l’année passée que certains États ont cherché à s’ingérer dans les processus politiques d’autres États. Nous ne sommes pas à l’abri des conflits et des guerres de grande échelle et je crois qu’il est important que nous nous posions ces questions. Dans un monde où nous sommes confrontés aux pressions du changement climatique, des migrations de grande échelle, des problèmes de sécurité de l’eau et de sécurité alimentaire, du lien entre l’eau, l’énergie et l’alimentation, je crois qu’il nous faut nous inquiéter de ce que certains groupes aux ressources importantes pourraient faire, tout autant que des loups solitaires.

DH Que faut-il retenir de ce qui se passe sur les réseaux sociaux avec la propagande russe et les élections quant à l’élément humain dans l’usage abusif de l’IA ? Les données personnelles peuvent être utilisées à des fins positives (marketing) ou à des fins négatives (manipulation).

SOH Il me semble que la manipulation russe nous montre qu’il existe beaucoup plus de moyens d’influence que ce dont nous sommes conscients et ce type de chose pourrait se produire à plus grande échelle. C’est un signe précurseur de ce qui risque d’arriver si nous ne sommes pas prudents par rapport à tout ceci. À titre d’exemple, il paraît que des hackers russes auraient envoyé environ 10 000 tweets ciblés aux membres du Département de la Défense (aux États-Unis) et à d’autres personnes. Aujourd’hui, cela veut sans doute dire qu’un grand nombre de personnes a écrit ces tweets, mais comme je le disais précédemment, si on arrivait à automatiser certains de ces processus, on pourrait voir des tentatives d’interférence à plus grande échelle, ou alors ces outils pourraient devenir accessibles à davantage de monde. Nous devons vraiment réfléchir à l’utilisation qui sera faite de ces technologies, sachant que de toute évidence, les personnes qui mettent au point les techniques qui sous-tendent ce type d’automatisation ne le font pas en vue de permettre le piratage d’élections. Elles le font à des fins inoffensives diverses et variées visant à réduire la pénibilité de toutes sortes de besognes qui nous font perdre du temps.

« Ceci nous montre bien qu’il existe, pour beaucoup de ces technologies, le potentiel d’une double utilisation ; il est tout à fait possible que le but de leur mise au point ne soit que bénéfique, mais il ne faut pas oublier que certaines personnes trouveront moyen de détourner ces objectifs à des fins qui ne seront pas nécessairement positives. »

DH Quelles doivent être les préoccupations des citoyens ordinaires en ce qui concerne l’IA ?

SOH Je pense que les citoyens ordinaires feraient bien de réfléchir à leur profession et aux compétences nécessaires dans leur travail afin de déterminer la probabilité d’automatisation de ces compétences dans 10 ou 20 ans. Ils devraient également réfléchir à l’éducation de leurs enfants et s’assurer que cette éducation promeut des compétences de souplesse, de créativité et de résolution des problèmes car ces compétences seront cruciales dans un monde où de nouvelles professions seront créées alors que de nombreux secteurs traditionnels d’emploi disparaîtront.

Le citoyen ordinaire devrait être extrêmement prudent par rapport à sa sécurité en ligne. Le type d’attaques auxquelles il risque d’être confronté ira de l’attaque rudimentaire et facilement identifiable à l’attaque plus sophistiquée et à laquelle il est facile de se laisser prendre.

Le citoyen ordinaire devrait également être prudent par rapport aux méthodes technologiques qui permettent des collectes beaucoup plus larges d’informations sur lui, ce qui pourrait influer sur ses agissements, que ce soit par des acteurs commerciaux ou par l’État. Par conséquent, il devrait s’assurer de bien exercer ses droits démocratiques et vérifier que les règles et politiques adoptées par rapport à ces technologies sont conformes à ses valeurs.

DH Que signifie l’usurpation d’identité dans ce monde moderne de l’IA ?

SOH Bonne question. Nous connaissons tous déjà la question de la fraude bancaire ou de la fraude par carte de crédit. Dans un monde où il est possible de créer un fichier vocal dans lequel vous semblez délivrer un message que j’ai écrit, il me semble qu’on pourrait voir un niveau bien plus sophistiqué d’usurpation d’identité. Et étant donné l’environnement des fake news dans lequel nous vivons et toutes les personnes qui démentent ce qu’elles ont bel et bien dit, il va devenir de plus en plus difficile de démêler le vrai du faux.

DH Et qu’est-ce qui empêche les machines de prendre réellement le contrôle, par exemple en cas de dérèglement soudain… Imaginons que l’IA ait prit la décision d’éteindre le réseau pour préserver sa propre intégrité… Les êtres humains auront-ils toujours les moyens de contourner la mauvaise décision d’un ordinateur ?

SOH Pour l’instant, oui, et quand je dis pour l’instant, je veux dire par là pendant les années et probablement les décennies à venir. À court terme, ce qui est le plus inquiétant, c’est qu’il est possible qu’on ne se rende pas compte qu’une machine est sur la mauvaise voie avant qu’il ne soit trop tard pour intervenir et éviter les dommages.

Comme exemple précoce de ce type de situation, on pourrait citer le crash de la bourse [en 2010] où le comportement anormal d’algorithmes (entre autres) a eu un effet boule de neige. Tout est allé si vite que le temps que les êtres humains puissent faire quelque chose, la bourse avait déjà enregistré des pertes majeures.

Il nous faut être extrêmement prudents lors de l’introduction de systèmes d’IA dans une infrastructure de plus en plus critique et il est essentiel à tout moment d’essayer de comprendre comment ces systèmes en arrivent aux décisions qu’ils prennent. Quelles sont les circonstances dans lesquelles ils fonctionneront bien ? Quelles sont les circonstances dans lesquelles ils échoueront ?

Nous n’avons pas encore atteint, de loin, le niveau technologique qui permettrait aux systèmes d’IA de faire preuve d’une grande créativité dans la résolution de problèmes en vue d’objectifs définis, ou de prendre des mesures pour éviter une rupture de leur fonctionnement, si ce n’est dans des contextes très simples de jeux. Ceci est préoccupant pour les chercheurs à long terme, mais ce n’est pas la préoccupation qui pour l’instant doit empêcher le citoyen ordinaire de dormir la nuit à mon avis.